Wir sind uns ja hier alle sicher, dass Spracherkennung, die Umsetzung des gesprochenen Worts in geschriebenen Text bereits in wenigen Jahren eine Selbstverständlichkeit sein wird wie warmes Wasser aus der Leitung. Während Konferenzmitschnitte, Diagnosen und Kanzleikorrespondenz mehrheitlich weiterhin von einer Schreibkraft transkribiert werden, machen „Siri“ und „Cortana“ di Interaktion mit Betriebssystemen interaktiver, Sprachsteuerung des Multimediasystems in modernen Autos ist auch keine Magie mehr und ich gehe davon aus, dass Geheimdienste die Milliarden an Terabyte an mitgeschnittenem Telefonverkehr auch nicht wirklich durch menschliche Ohren in Echtzeit abhören lassen. Kurzum, wir werden es alle noch erleben, mittels Sprache mit Maschinen zu kommunizieren.

Für den deutschen Sprachraum hat sich die Firma Nuance mit ihrem Dragon Naturally Speaking als quasi Monopolist am Markt platziert; wer seine Diktate in Text verwandeln will greift üblicherweise zu den Produkten des Anbieters von Sprach- und Bildbearbeitungslösungen und übt sich im „markier das“ und „neuer Absatz“. Was nicht heißt, dass keine anderen Unternehmungen, Universitäten oder Behörden zu diesem Thema forschen. Die „Carnegie Mellon University“ aus Pittsburgh, Pennsylvania forscht mittlerweile seit 20 Jahren in diesem Feld und hat u.a. CMU Sphinx vorzuweisen.

Das Toolkit lässt sich unter einer BSD Lizenz (die u.a. die kommerzielle Verwendung ermöglicht) auf Sourceforge herunterladen. Das Projekt wendet sich ausdrücklich nicht an Endkunden, die eine 1-Klick-Installation erwarten, sondern beinhaltet eine Serie von Werkzeugen zur Erstellung einer eigenen, sprecherunabhängigen Spracherkennungs-Applikation aus den beinhalteten Spracherkennungs-Engines und dem Akustikmodell-Trainer, programmiert in C. Sun Microsystems war an der Entwicklung von Sphinx 4 beteiligt und steuerte dem Projekt eigene Expertise bei der Softwareentwicklung bei, ebenso wie Entwickler vom MERL, MIT und CMU.

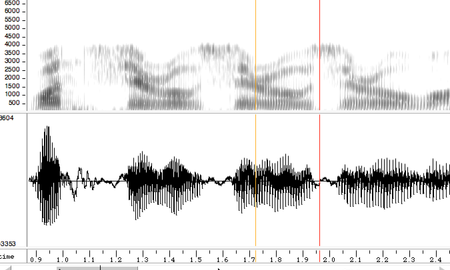

US und UK-Englisch, Französisch, Mandarin, Deutsch, Holländisch und Russisch stehen als Sprachmodelle bereits zur Verfügung, mit dem Toolkit lassen sich aber alle anderen Sprachen implementieren. Um die Plattform-Unabhängigkeit zu garantieren, verzichtet man auf Dekoder, die Eingabe erfolgt in 16khz 16bit little-endian mono, wobei 8kHz möglich ist. Softwareentwickler können Ihre Eingabeoptionen daraufhin abstimmen. Grund dafür ist, dass Soundaufnahmen je nach Plattform sehr unterschiedlich sind; Android nutzt den Java Audio Recorder, Python bindings setzen auf PyAudio, unter Windows wird mit WinMM Api aufgezeichnet, unter Windows Phones wieder mit einer anderen API. Alle diese Schnittstellen sind nicht kompatibel untereinander.

Kurzum, CMU Sphinx ist ein Plattform unabhängiges Toolkit zur Entwicklung von Spracherkennungslösungen auch für mobile Geräte oder den Raspberry P. Das Projekt wird eifrig gepflegt und beinhaltet auch die Option für einen professionellen Support. Es handelt sich um kein Produkt für Endanwender, illustriert aber, wie die Forschung in Richtung sprecher-unabhängige Spracherkennungslösungen funktioniert. Bis dahin bleibt Dragon Naturally Speaking die Spracherkennung der Wahl.